Verzonden op 13-02-2026 07:45

xAI lanceert Collaborative Notes om context samen met AI te schrijvenxAI introduceerde Collaborative Notes, een feature waarmee je samen met AI context en documentatie kunt opstellen. In plaats van een chatbot te vragen om een samenvatting te genereren, werk je real-time samen aan dezelfde tekst. Dit is relevant voor teams die kennisdocumentatie snel willen opbouwen of bijwerken. Denk aan onboarding-docs, technische specificaties of meeting-notes die tijdens de vergadering al vorm krijgen. De AI vult gaten aan en stelt structuurverbeteringen voor terwijl jij schrijft. Het grote risico: als de AI context hallucinaties inbrengt die niet direct worden gecorrigeerd, verspreiden die zich sneller dan bij een traditionele Q&A-flow. Zorg dat iemand met domeinkennis de output verifieert voordat het in productie gaat. Test dit voor een terugkerende documentatietaak – bijvoorbeeld sprint-retrospectives of API-release notes – en meet of je sneller klaar bent zonder kwaliteitsverlies.

|

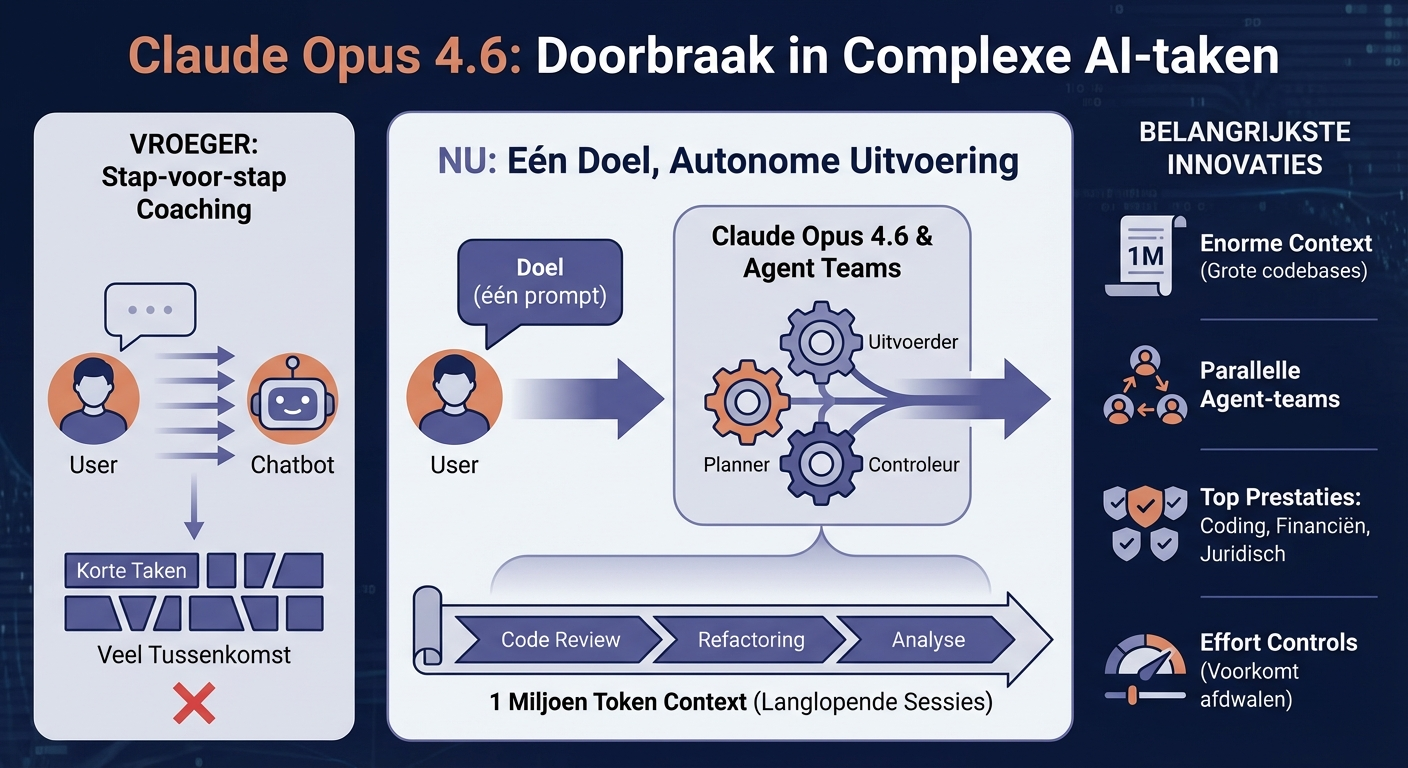

Anthropic lanceert Claude Opus 4.6 met 1M token context en agent-teamsOp 5 februari 2026 lanceerde Anthropic Claude Opus 4.6, een model dat specifiek is gebouwd voor langlopende, complexe taken in grote codebases. De belangrijkste doorbraak: een context window van 1 miljoen tokens en 'agent teams' – meerdere AI-agents die parallel aan één taak werken zonder dat je elke stap hoeft aan te sturen. Voor ontwikkelteams betekent dit minder handmatig tussenkomen bij lange sessies. In plaats van een chatbot stap voor stap te coachen, geef je een doel en laat je het systeem plannen en uitvoeren. Opus 4.6 scoort bovenaan op coding, financiële analyse en juridische redenering – competenties die direct beschikbaar zijn in Claude Cowork. De kanttekening: agents die langer draaien verzamelen meer context, maar kunnen ook verder afdwalen. Anthropic biedt nu 'effort controls' om te voorkomen dat agents onbeperkt blijven zoeken naar perfectie. Concreet: test of jouw bestaande Claude-workflows profiteren van de langere context door een typische multi-step taak (bijvoorbeeld code review + refactoring) in één prompt te gieten.

|

OpenAI lanceert GPT-5.3 Codex als computer-use agentExact 20 minuten na Anthropic's aankondiging op 5 februari 2026 counterde OpenAI met GPT-5.3 Codex. Waar eerdere Codex-versies codefragmenten genereerden, is dit model een volwaardige computer-use agent die browsers, terminals en IDE's kan bedienen. De timing is geen toeval: beide labs strijden om dezelfde enterprise-budgetten voor AI-coding. Voor jouw organisatie betekent dit dat de prijs-prestatieverhouding van AI-codering snel verbetert, maar ook dat vendor lock-in gevaarlijker wordt als je zwaar inzet op één platform. OpenAI communiceert schaars over de precieze capabilities; de officiële release notes ontbreken nog. Dat maakt benchmarken lastig. Overweeg parallel testen: draai dezelfde coding-taak door Opus 4.6 én GPT-5.3 Codex om te zien welk model beter past bij jouw tech stack en workflow.

|

Perplexity introduceert Model Council: één query, drie AI-modellen tegelijkPerplexity onthulde een nieuwe feature die één zoekopdracht parallel door drie verschillende AI-modellen stuurt en de antwoorden aggregeert. Het idee: verschillende modellen hebben verschillende sterke punten, dus waarom niet alle drie raadplegen? Voor research-intensieve teams kan dit tijd besparen: in plaats van handmatig te switchen tussen ChatGPT, Claude en Gemini, krijg je een synthetisch antwoord dat rekening houdt met meerdere perspectieven. De trade-off is dat je minder controle hebt over welk model welk deel beantwoordt. De vraag blijft of de extra latency en kosten opwegen tegen de kwaliteitswinst. Perplexity geeft geen harde cijfers over responstijd of pricing. Test dit voor complexe vragen waar je normaal meerdere bronnen checkt – bijvoorbeeld marktanalyse of technische troubleshooting – en meet of de uitkomst beter is dan je huidige workflow.

|

Cursor toont dat duizenden agents grote codebases kunnen onderhoudenCursor publiceerde een case waarin duizenden AI-agents parallel een grote, legacy codebase onderhielden en doorontwikkelden. Geen proof-of-concept, maar een productie-scenario dat laat zien dat agentic coding werkt op schaal. Voor engineering-teams met technische schuld is dit relevant: in plaats van maanden refactoring door menselijke devs, kunnen agents repetitieve migraties, dependency-updates en documentatie parallel afhandelen. De bottleneck verschuift van schrijfsnelheid naar review-capaciteit. De context-drift die AlphaSignal noemt blijft een risico: hoe meer agents tegelijk draaien, hoe groter de kans op conflicten en subtiele bugs die door geautomatiseerde tests glippen. Kijk of jouw CI/CD-pipeline klaar is voor een stroom aan automatische pull requests: kun je die reviews versnellen zonder kwaliteit in te leveren?

|

Augment Code versnelt AI-coding via Context Engine met MCPAugment Code lanceerde een Context Engine die gebruik maakt van het Model Context Protocol (MCP) om sneller en goedkoper context te leveren aan coding-modellen. MCP is een open standaard die tools, databases en codebases aan AI-modellen koppelt zonder vendor lock-in. Dit lost een praktisch probleem op: elk nieuw AI-model heeft opnieuw context nodig over jouw codebase, wat tokens en tijd kost. Door MCP te standaardiseren, kun je context één keer indexeren en hergebruiken over meerdere modellen. Voor teams die meerdere AI-tools naast elkaar gebruiken (bijvoorbeeld Cursor, GitHub Copilot en Claude) kan dit de setup-tijd drastisch verkorten. De kanttekening: MCP is nog jong, dus verwacht friction bij edge cases. Check of jouw huidige AI-tooling al MCP ondersteunt – zo ja, dan kun je experimenten sneller opschalen zonder elke keer opnieuw te integreren.

|