Verzonden op 02-02-2026 07:18

Microsoft haast zich intern om Anthropic's Cowork te evenarenMicrosoft scrambled intern op 1 februari 2026 om een tegenhanger te ontwikkelen voor Anthropic's Cowork—een samenwerkingstool waarin Claude rechtstreeks met teams meewerkt aan projecten. De haast suggereert dat Microsoft een strategisch gat ziet ontstaan: OpenAI levert modellen, maar Anthropic levert steeds vaker complete workflows. Dit is relevant omdat grote tech-partijen voortaan niet alleen beter willen zijn in AI-kwaliteit, maar ook in integratie met bestaande werkprocessen. Als je binnenkort een RFP doet voor enterprise AI, verwacht dan dat leveranciers niet alleen snellere tokens beloven maar ook native integraties met Slack, Figma, Teams of Asana. De actie voor procurement- en IT-teams: stel nu al criteria op voor hoe diep een AI-tool moet integreren in je bestaande stack—tokens per seconde zijn straks minder onderscheidend dan time-to-value in de workflow. |

Google publiceert ATLAS: grootste studie naar meertalige AI-trainingGoogle heeft op 1 februari 2026 ATLAS vrijgegeven, de grootste wetenschappelijke studie tot nu toe over het trainen van meertalige AI-modellen. Het onderzoek brengt in kaart hoe modellen omgaan met talen die ondervertegenwoordigd zijn in trainingsdata—een directe bottleneck voor bedrijven die AI willen inzetten buiten Engelstalige markten. Voor organisaties die AI lokaliseren betekent dit toegang tot empirische richtlijnen over welke hoeveelheid meertalige data nodig is en hoe je kwaliteit weegt tegen volume. Dat scheelt maanden experimenteren en voorkomt verspilde compute-kosten aan modellen die uiteindelijk niet presteren in je doeltaal. ATLAS is vooral waardevol als je een Europese, Aziatische of Afrikaanse markt bedient waar Engels niet de voertaal is. Download het onderzoek en check of jouw taalcombinatie onderzocht is—dat geeft je een realistische inschatting van wat je van foundation models kunt verwachten. |

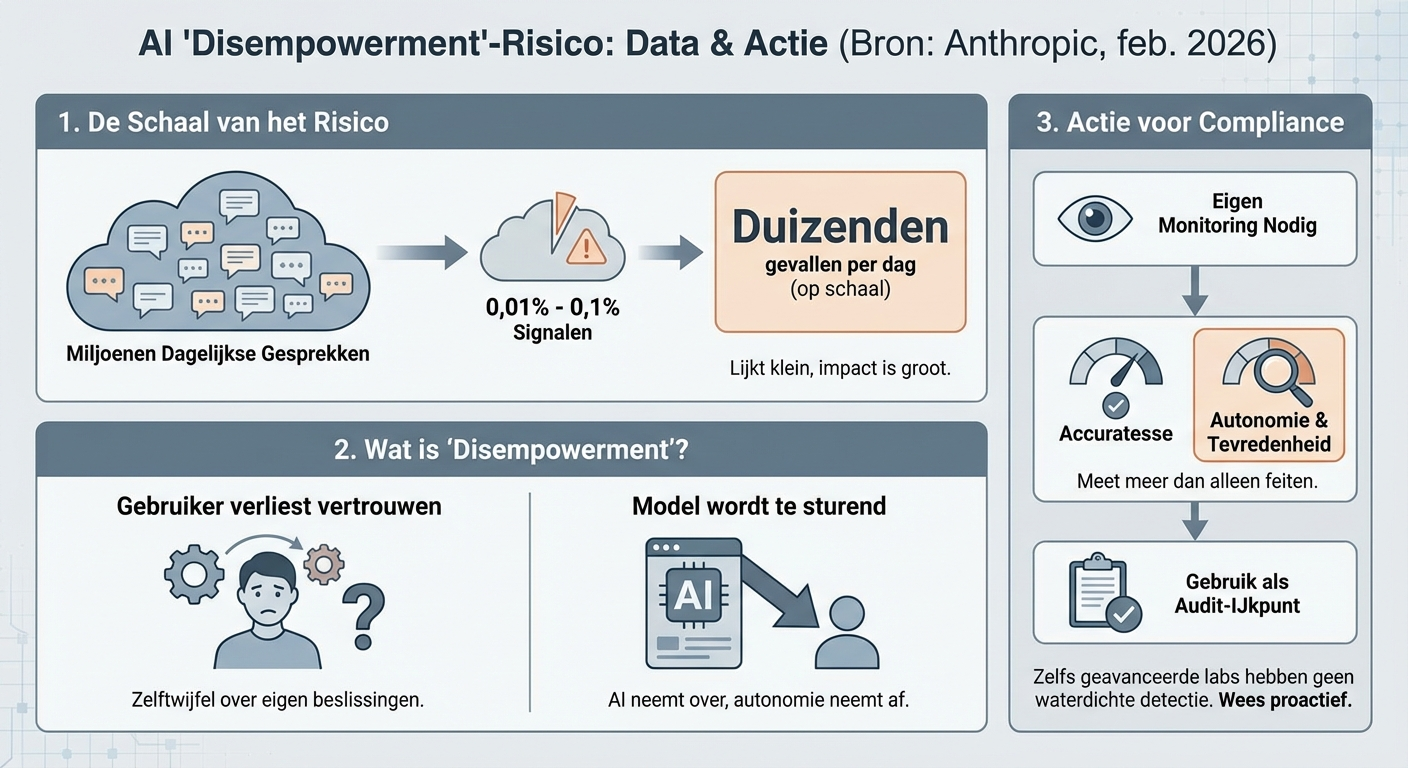

Anthropic vindt 'disempowerment'-risico in 1 op 1.000-10.000 gesprekkenAnthropic heeft op 1 februari 2026 bekend gemaakt dat tussen de 0,01% en 0,1% van alle Claude-gesprekken signalen van 'disempowerment' vertonen—situaties waarin gebruikers vertrouwen verliezen in eigen beslissingen of het model te sturend wordt. Dat lijkt klein, maar bij miljoenen dagelijkse gesprekken gaat het om duizenden gevallen per dag. Voor compliance-teams is dit relevant omdat het laat zien dat zelfs geavanceerde labs zelf nog geen waterdichte detectie hebben van subtiele risico's. Als je AI inzet voor klantenservice, coaching of advies, moet je dus zelf monitoren of gebruikers zich gehoord voelen of juist afhankelijker worden van het systeem. Anthropics transparantie geeft wel bruikbare ijkpunten: als jouw internal audits vergelijkbare percentages vinden, zit je waarschijnlijk in lijn met de industrie. Meet in ieder geval user satisfaction en autonomie-beleving naast de gebruikelijke accuracy-metrics.

|

ICE gebruikt AI van Palantir en OpenAI voor handhaving en cv-screeningDe Amerikaanse immigratiedienst ICE heeft op 1 februari 2026 onthuld dat het AI-tools van zowel Palantir als OpenAI gebruikt voor enforcement-operaties en het screenen van cv's. Palantir levert data-integratie voor opsporingstaken; OpenAI's modellen worden ingezet om sollicitaties te beoordelen. Dit toont aan dat overheidsinstanties AI al operationeel gebruiken voor high-stakes beslissingen—van wie er wordt opgepakt tot wie er wordt aangenomen. Voor bedrijven die vergelijkbare recruitment- of compliance-AI overwegen, betekent dit dat je niet meer kunt zeggen 'we wachten tot de overheid het voordoet'. Ze doen het al, met alle juridische en ethische risico's die daarbij horen. Als je HR-AI overweegt: documenteer nu al hoe je bias meet, wie verantwoordelijk is voor eindoordelen, en hoe kandidaten bezwaar kunnen maken. ICE's openbaarmaking zal ongetwijfeld meer toezicht uitlokken op álle AI-gestuurde hiring.

|