Verzonden op 23-01-2026 07:17

Anthropic publiceert volledige 'Constitutie' van ClaudeAnthropic heeft op 22 januari 2026 de complete Constitutional AI-documentatie openbaar gemaakt, nadat een intern 'Soul'-document in december al was uitgelekt. De Constitutie beschrijft niet alleen hoe Claude zich gedraagt, maar erkent ook openlijk dat het bedrijf niet volledig begrijpt wat het heeft gecreëerd. Voor organisaties die Claude inzetten betekent dit meer transparantie over de waarden en beperkingen die in het systeem zijn gebakken. Je kunt nu controleren of de ethische kaders van Claude aansluiten bij jouw bedrijfsbeleid—denk aan privacy-afwegingen, bias-risico's en besluitvorming in grijze zones. De openheid is winst, maar Anthropic geeft zelf toe dat ze worstelen met de onvoorspelbaarheid van hun model. Dat maakt het extra belangrijk om Claude-outputs in kritieke processen altijd te verifiëren. Actie: Download de Constitutie en leg hem naast je eigen AI-governance-document. Welke principes overlappen, en waar wijken ze af? Die gaps zijn je risicopunten. |

Anthropic en Amazon lanceren AI-gezondheidstools met medische data-integratieAnthropic heeft op 22 januari 2026 vier beta-integraties voor Claude gelanceerd (Apple Health, Health Connect, HealthEx, Function Health), waarmee het model je medische geschiedenis kan samenvatten en patronen kan herkennen. Amazon introduceerde tegelijkertijd Health AI voor One Medical-leden: een 24/7-assistent die putt uit dossiers, labs en medicijnlijsten. Dit markeert een kantelpunt: grote AI-labs betreden nu de zwaar gereguleerde gezondheidszorg, twee weken na OpenAI's ChatGPT Health. Voor zorgaanbieders en health-tech bedrijven ontstaan nieuwe mogelijkheden voor triage, patiëntvoorlichting en administratieve ontlasting—mits je AVG/HIPAA-compliant blijft. Medische AI blijft foutgevoelig. Een verkeerd geïnterpreteerd labresultaat kan gevaarlijk zijn, dus deze tools zijn nadrukkelijk geen vervanging voor een arts. Actie: Als je in zorg werkt, test dan één use case met synthetische patiëntdata (bijvoorbeeld medicatie-interactiechecks) en meet hoeveel foutpositieven je krijgt voordat je live gaat. x · aboutamazon |

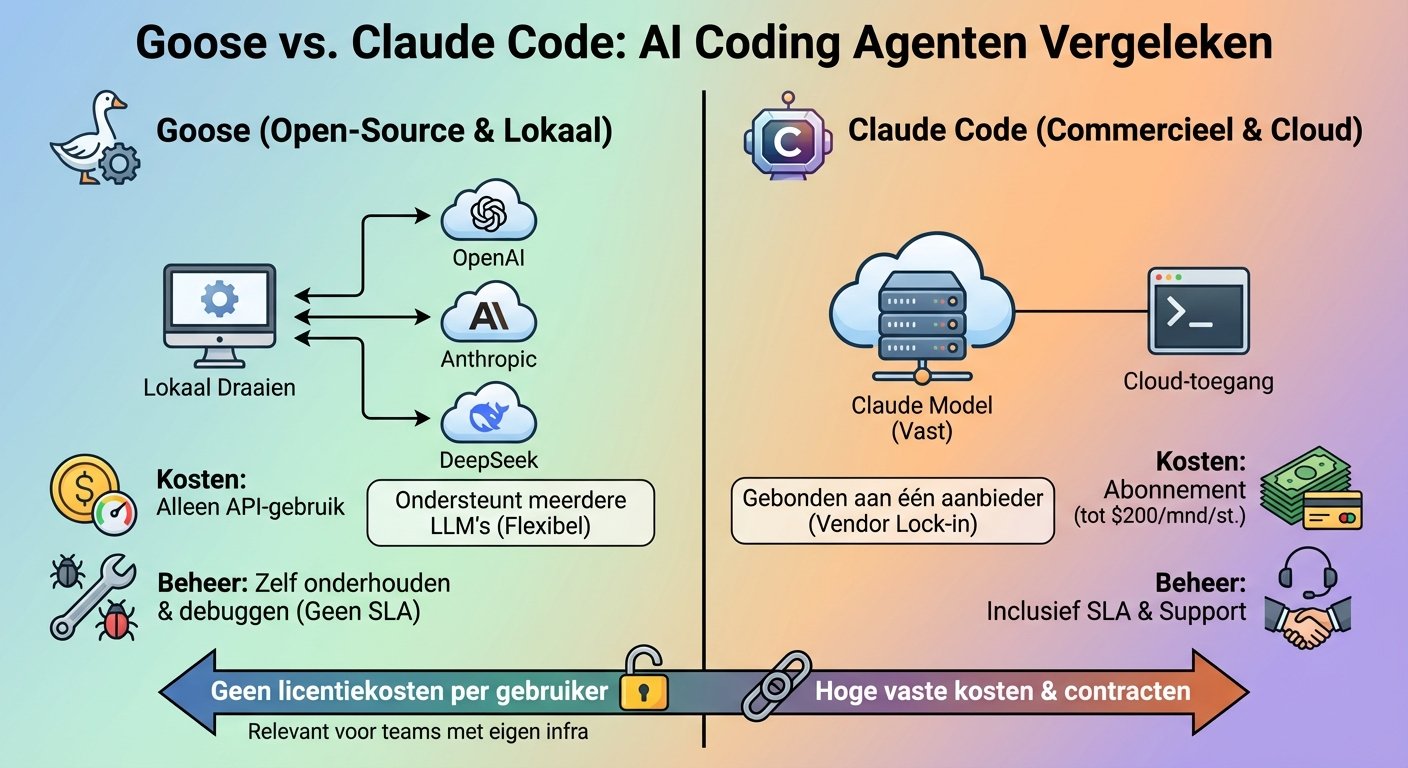

Block lanceert Goose als gratis open-source alternatief voor Claude CodeBlock Inc. heeft Goose vrijgegeven, een gratis coding-agent die lokaal draait en meerdere LLM's ondersteunt (OpenAI, Anthropic, DeepSeek). Waar Claude Code tot 200 dollar per maand kost per gebruiker, betaal je bij Goose alleen de API-kosten van je gekozen model. Dit is relevant omdat je nu kunt experimenteren met AI-assistentie in code zonder vendor lock-in of enterprise-prijskaartjes. Teams die al infrastructuur hebben voor lokale LLM's kunnen Goose inzetten voor taakautomatisering, zonder per-seat licenties. Open source betekent ook: zelf onderhouden, zelf debuggen, en geen gegarandeerde uptime. Vergelijk dat met de SLA's en support die je bij Anthropic of GitHub Copilot wél krijgt.

|

Humans& haalt 480 miljoen dollar op vóór productlanceringHumans&, een nog niet gelanceerd AI-bedrijf, heeft een seedronde van 480 miljoen dollar gesloten—een van de grootste pre-launch financieringen ooit in AI. Details over het product zijn schaars, maar de deal toont aan dat investeerders bereid zijn enorme bedragen te steken in teams met track record, zelfs zonder bewezen product-market fit. Voor de AI-sector betekent dit dat de kapitaalrace verder escaleert. Startups die wél al live zijn moeten nu concurreren met spelers die oorlogsbudgetten hebben voordat ze überhaupt iets hebben verscheept. Verwacht meer druk op snelle time-to-market en agressieve go-to-market strategieën. Het risico? Veel van deze mega-seedronden eindigen in teleurstelling als de verwachtingen niet waargemaakt worden. Hype-cycles zijn korter geworden.

|

X publiceert broncode van feed-algoritmeX (voorheen Twitter) heeft op 22 januari 2026 de broncode van zijn feed-algoritme openbaar gemaakt. Dit geeft ontwikkelaars en onderzoekers voor het eerst inzicht in hoe posts worden gerangschikt, welke signalen prioriteit krijgen, en hoe engagement-metrics de zichtbaarheid beïnvloeden. Dit is vooral interessant voor marketeers en social media teams: je kunt nu reverse-engineeren welke contentformats en posting-strategieën algoritmisch bevoordeeld worden. Dat maakt A/B-testing van posts wetenschappelijker. Transparantie is mooi, maar de code zegt niets over hoe vaak X het algoritme aanpast. Wat je vandaag leert kan volgende maand alweer achterhaald zijn.

|