Verzonden op 01-01-2026 17:52

Subreddit r/RealOrAI toont grens tussen echt en AI—detectie wordt volkssportDe Reddit-community r/RealOrAI post regelmatig video's van extreme situaties (reuzenratten, katten die muizen op hun kop krijgen) en vraagt of het AI-gegenereerd is. Veel clips zijn zo onwaarschijnlijk dat ze bijna niet echt kunnen zijn, maar soms blijken ze tóch authentiek. Dit illustreert een groter probleem: zelfs tech-savvy mensen kunnen niet meer betrouwbaar onderscheiden of content synthetisch is. Voor organisaties die met user-generated content werken (media, marketing, compliance) wordt verificatie urgent—namaak-reviews, nepklachten of valse testimonials zijn straks niet meer te spotten met het blote oog. Watermerking (zoals C2PA-standaarden) helpt, maar werkt alleen als platforms en tools het adopteren. Overweeg intern beleid: vereis bronverificatie voor visueel materiaal in campagnes en train teams om verdachte patronen te herkennen (vreemde handen, inconsistente schaduwen, onlogische fysica). |

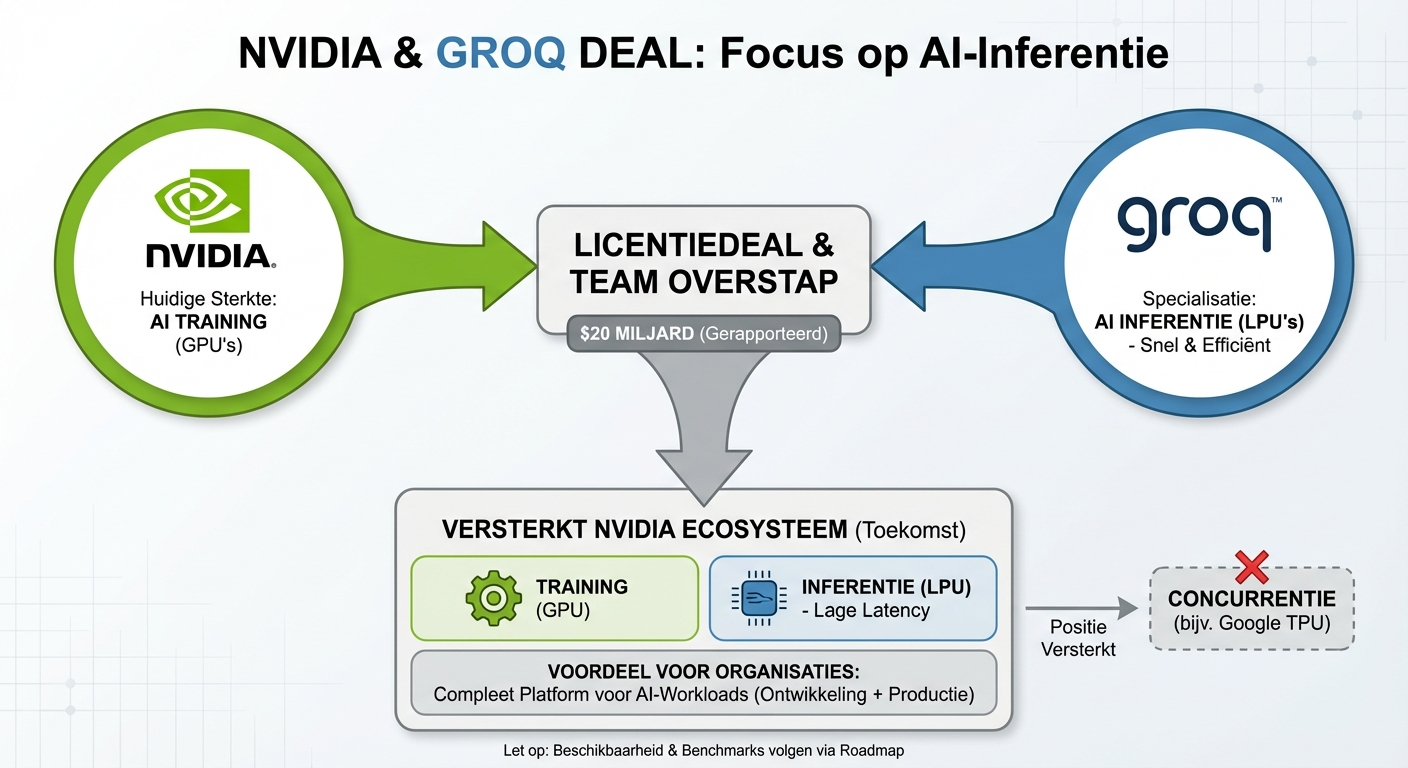

Nvidia koopt Groq-technologie voor 20 miljard dollar—snelste AI-inference komt in huisNvidia sluit op 24 december 2025 een licentiedeal van naar verluidt 20 miljard dollar met chipmaker Groq, wiens Language Processing Units (LPU's) bekend staan om extreem snelle en kostenefficiënte AI-inferentie. De CEO, president en andere sleutelfiguren van Groq stappen over naar Nvidia, wat de deal feitelijk dicht bij een overname brengt. Voor organisaties betekent dit dat Nvidia's ecosysteem straks naast trainings-hardware (GPU's) ook de beste inference-chips aanbiedt—relevant als je overwegt waar je productie-workloads draait. Groq's architectuur is geoptimaliseerd voor lage latency bij grote taalmodellen, iets waar GPU's minder efficiënt in zijn. De deal versterkt Nvidia's positie tegenover concurrenten zoals Google (TPU) en startups die gespecialiseerde inference-chips bouwen. Let wel: licentie betekent dat Groq's IP naar Nvidia gaat, maar het is nog onduidelijk hoe snel deze chips beschikbaar komen voor externe klanten. Houd Nvidia's roadmap-updates in de gaten als je inference-kosten wilt optimaliseren; de komende maanden verschijnen waarschijnlijk benchmarks die Groq-LPU's vergelijken met bestaande alternatieven.

|

Lemon Slice haalt 10,5 miljoen op voor foto-naar-avatar technologie—video-agents krijgen gezichtAI-lab Lemon Slice kondigde op 23 december 2025 een seed-ronde van 10,5 miljoen dollar aan (Y Combinator en Matrix Partners) om photo-to-avatar-technologie verder te ontwikkelen. Upload één foto, kies een stem, en je kunt videochatten met een digitaal persoon die eruitziet als die foto—bedoeld voor klantenservice, sales-demo's of interne training. De gedachte: AI-interacties voelen nu nog robotachtig omdat ze geen gezicht hebben; avatars kunnen dat doorbreken. Voor organisaties opent dit deuren naar geschaalde, gepersonaliseerde video-ervaringen zonder camera-crew of acteurs: denk aan onboarding-video's die automatisch de naam van de nieuwe medewerker noemen, of support-agents die 24/7 beschikbaar zijn mét menselijk gezicht. De kanttekening: uncanny valley-effecten liggen op de loer; te kunstmatige gezichten schrikken gebruikers juist af. Test een pilot met een klein publiek voordat je avatar-interfaces breed utrolt—meet of gebruikers de ervaring prettiger vinden dan tekst of audio-only. techcrunch · x |

Zhipu AI's GLM-4.7 overtreft open-source concurrentie—kleinere modellen worden krachtigerHet Chinese Zhipu AI (ook bekend als Z.ai) heeft GLM-4.7 gelanceerd, een open-source model dat volgens benchmarks beter scoort dan vergelijkbare modellen zoals Meta's Llama en Mistral's nieuwste releases. De exacte cijfers stonden niet in de bronnen, maar meerdere nieuwsbrieven markeren dit als belangrijk voor de open-source-gemeenschap. Voor organisaties die liever geen closed-source API's gebruiken (vanwege data-privacy of vendor lock-in), biedt GLM-4.7 een alternatief dat lokaal of in eigen cloud kan draaien. Kleinere, efficiëntere modellen maken AI-toepassingen goedkoper en sneller—relevanter dan ooit nu inference-kosten een bottleneck zijn bij schaalgebruik. Zhipu AI is minder bekend in het Westen, dus documentatie en community-support kunnen beperkter zijn dan bij Llama of Mistral. Download het model vanaf Hugging Face of de Zhipu-website en test het op je eigen use case; vergelijk latency en output-kwaliteit met je huidige provider voordat je switched. |