Verzonden op 12-12-2025 10:30

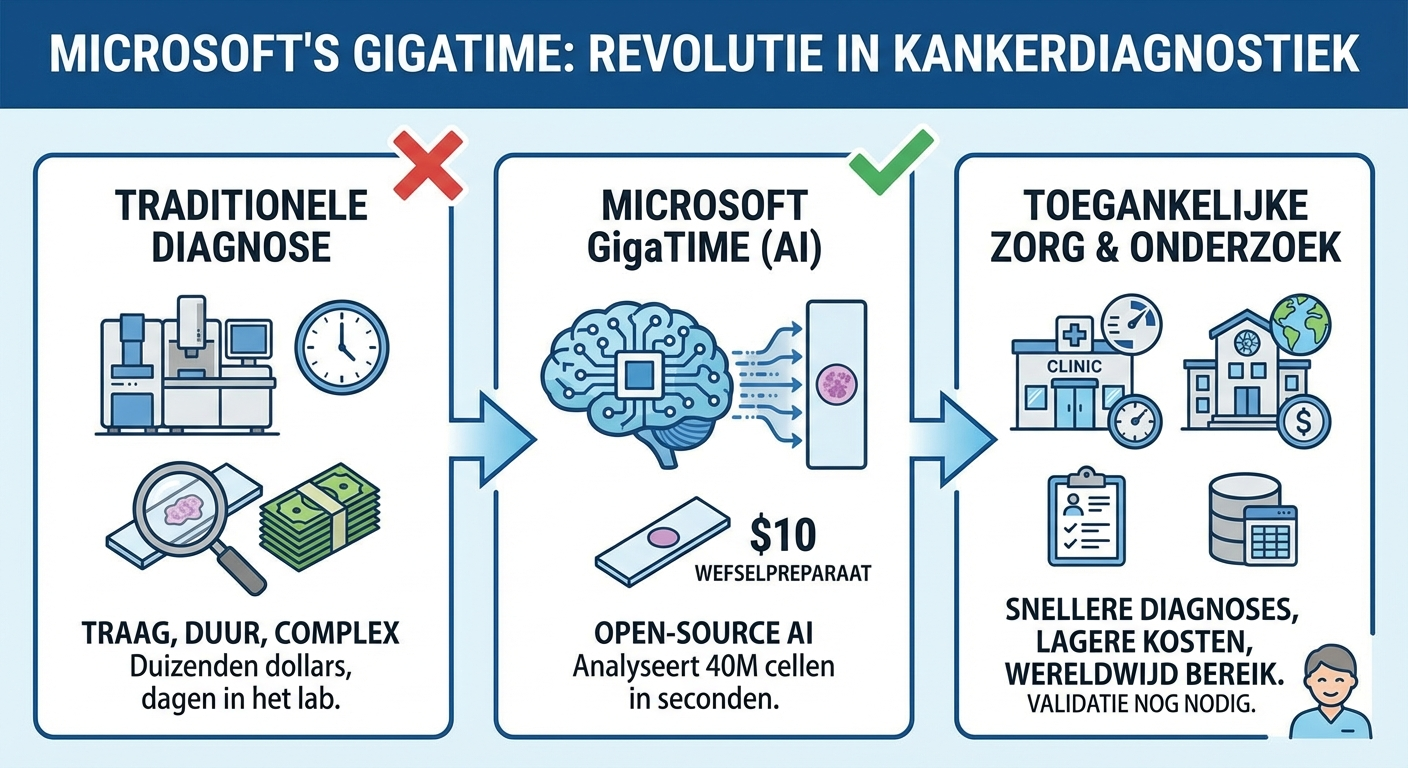

Microsoft maakt geavanceerde kankerdiagnostiek toegankelijk met open-source AIMicrosoft's nieuwe GigaTIME-model analyseert 40 miljoen celsamples in seconden en maakt gedetailleerde tumorkarteringen vanaf een weefselpreparaat van 10 dollar. Wat vroeger duizenden dollars kostte en dagen duurde in het lab, wordt nu razendsnel en betaalbaar. Dit is relevant omdat diagnostiek nu binnen handbereik komt van kleinere klinieken en onderzoeksinstellingen wereldwijd. Door het model open-source te maken, verlaagt Microsoft de toegangsdrempel voor kankeronderzoek drastisch. Voor ziekenhuizen en labs betekent dit: snellere diagnoses, lagere kosten per patiënt en mogelijkheden voor gepersonaliseerde behandelplannen op basis van gedetailleerde tumorinformatie. Onderzoeksinstellingen kunnen nu datasets analyseren die voorheen onbetaalbaar waren. De validatie in echte klinische settings moet nog komen – AI-modellen presteren vaak anders in de praktijk dan in gecontroleerde onderzoeksomgevingen.

|

Amazon Ring introduceert AI-gezichtsherkenning voor deurbellenAmazon rolt AI-aangedreven gezichtsherkenning uit voor Ring-deurbellen, waarmee het apparaat automatisch bekende gezichten kan identificeren. Dit markeert een verschuiving in smart home security: van bewegingsdetectie naar persoonsherkenning. Voor consumenten betekent dit minder valse alarmen en gepersonaliseerde notificaties ('pakketbezorger gedetecteerd' versus 'onbekende persoon'). Bedrijven met recepties of beveiligde toegangen kunnen hiermee bezoekersbeheer automatiseren en inlogprocedures vereenvoudigen. De technologie zou ook toegangssystemen kunnen vervangen die nu nog werken met badges of pincodes. Privacy-implicaties zijn aanzienlijk: gezichtsdata wordt lokaal of in de cloud opgeslagen, en AVG-compliance vereist expliciete toestemming van iedereen die gefilmd wordt. In Europa liggen de juridische grenzen strakker dan in de VS. |

Mistral lanceert Devstral 2 en nieuwe coding assistantMistral brengt Devstral 2 uit, een verbeterde AI-codeermodel, samen met een bijbehorende coding assistant voor ontwikkelaars. Dit komt op een moment dat de strijd om het beste AI-programmeermodel heviger wordt – GitHub Copilot, Cursor en nu dus Mistral vechten om marktaandeel. Voor ontwikkelteams betekent dit meer keuze, maar ook fragmentatie van tooling. De praktische impact: snellere code reviews, geautomatiseerde refactoring en contextbewuste suggesties tijdens het programmeren. Teams die al met Claude of GPT werken, kunnen nu benchmarken of Mistral's aanpak beter bij hun codebase past. Let op: geen enkel model schrijft productie-klare code zonder menselijke review. De assistent versnelt werk, maar introduceert ook technische schuld als je blind vertrouwt op gegenereerde code. |

OpenAI, Anthropic en Block stellen standaard voor AI-agents opOpenAI, Anthropic en Block werken samen aan gezamenlijke standaarden voor AI-agents – een poging om interoperabiliteit en veiligheid te borgen terwijl agents steeds autonomer worden. Waarom nu? Agents die zelfstandig taken uitvoeren (van boekhouden tot klantenservice) worden mainstream, maar elke leverancier bouwt in zijn eigen silo. Zonder standaarden krijg je vendor lock-in en beveiligingsrisico's. Voor organisaties die agents inzetten betekent dit: investeren in systemen die straks compatibel blijven, en verwachten dat compliance-eisen (audit trails, stopknoppen, transparantie) snel gestandaardiseerd worden. Vroege adopters kunnen nu al invloed uitoefenen op wat die standaarden worden. De echte test komt als concurrenten zoals Google en Meta zich wel of niet aansluiten – zonder brede adoptie blijft het een papiertijger. |

AI-detectietools zijn onbetrouwbaar, zelfs voor de BijbelAI-detectietools zoals GPT Zero scoren de Bijbel voor 88% als 'door ChatGPT geschreven'. Zelfs een van de makers van ChatGPT bevestigt: betrouwbare AI-detectie is onmogelijk. Het probleem is fundamenteel wiskundig: mensen kunnen robotachtig schrijven, AI's kunnen natuurlijk schrijven, en die overlap is enorm. Detectoren raden in feite, en scoren amper beter dan toeval op individuele teksten. Dit heeft directe gevolgen voor onderwijsinstellingen en contentteams die nu geld uitgeven aan detectietools. Stop ermee – je koopt een illusie. Focus in plaats daarvan op proceschecks: laat mensen hun denkproces uitleggen, werk met iteraties, of vraag om bronvermelding. Voor marketingteams: schrijf met een menselijke stem door specifieke details, persoonlijke observaties en onverwachte wendingen toe te voegen. AI herkent patronen; doorbreek die patronen bewust.

|