Verzonden op 08-09-2025 08:55

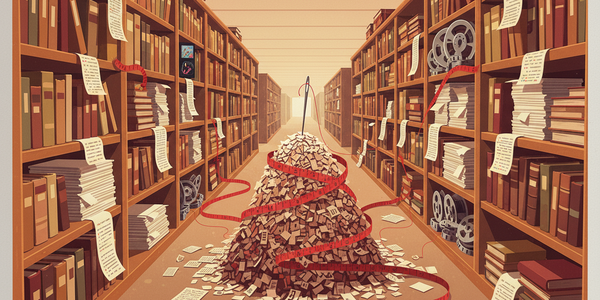

Google verdubbelt context window van Gemini 1.5 Pro naar 2 miljoen tokensGoogle heeft het context window van Gemini 1.5 Pro uitgebreid naar 2 miljoen tokens, nu beschikbaar in een publieke preview via de Google AI Studio. Dit is een verdubbeling van de vorige capaciteit en versterkt Google's positie in de race om de meest capabele modellen. Het stelt het model in staat om complete codebases, meerdere boeken of uren aan video te analyseren in één enkele prompt. De mogelijkheid om zulke enorme hoeveelheden data te verwerken creëert nieuwe toepassingen in complexe documentanalyse en grootschalige code-audits. De prijs is vastgesteld op $7 per miljoen tokens voor input boven de 128k. Hoewel de capaciteit indrukwekkend is, blijft de 'naald in de hooiberg'-test de echte maatstaf voor de effectiviteit van zo'n groot context window. Actie-tip: Test de capaciteit zelf. Upload een jaarverslag of een lang technisch document naar de Google AI Studio en vraag Gemini 1.5 Pro om een gedetailleerde SWOT-analyse op te stellen. |

Apple integreert 'Apple Intelligence' in iOS 18 en macOSApple heeft 'Apple Intelligence' onthuld, een reeks AI-functies die diep geïntegreerd worden in iOS 18, iPadOS 18 en macOS Sequoia. Hiermee stapt Apple serieus in de AI-wedloop, met een duidelijke focus op privacy door zoveel mogelijk op het apparaat zelf te verwerken in plaats van in de cloud. Voor organisaties betekent dit dat applicaties op Apple-apparaten straks gebruik kunnen maken van systeembrede AI-mogelijkheden, zoals het samenvatten van tekst en genereren van afbeeldingen. De aangekondigde integratie van ChatGPT voor complexere vragen (met toestemming van de gebruiker) opent ook nieuwe deuren. De functies zijn in eerste instantie als bèta beschikbaar en vereisen de nieuwste hardware (een iPhone 15 Pro of nieuwer), wat de adoptiesnelheid in de beginfase kan beperken. |

NVIDIA brengt open model Nemotron-4 uit voor genereren synthetische dataNVIDIA heeft Nemotron-4 340B gelanceerd, een familie van open modellen specifiek ontworpen om hoogwaardige synthetische data te genereren voor het trainen van andere taalmodellen. Dit is een strategische zet die de afhankelijkheid van kostbare, handmatig gelabelde datasets kan verminderen, een van de grootste knelpunten in AI-ontwikkeling. Voor bedrijven die eigen AI-modellen trainen, kan dit de ontwikkelkosten en -tijd aanzienlijk verlagen. De modellen zijn beschikbaar onder een licentie die commercieel gebruik toestaat, waardoor het een direct bruikbaar alternatief is voor het inkopen van data. De kwaliteit van een model is direct afhankelijk van de trainingsdata. Vertrouwen op puur synthetische data introduceert het risico op het versterken van model-bias of het creëren van een echokamer. Actie-tip: Als je een kleiner, gespecialiseerd model traint, experimenteer dan met een dataset die voor 10% is aangevuld met data gegenereerd door Nemotron-4, en meet de impact op de prestaties.

|

Stack Overflow en OpenAI sluiten partnerschap voor betere code-antwoordenStack Overflow gaat zijn data via een nieuwe API beschikbaar stellen aan OpenAI, met als doel de codeer-capaciteiten van ChatGPT te verbeteren. Deze samenwerking markeert een belangrijke verschuiving voor Stack Overflow, dat eerder terughoudend was over het gebruik van zijn content voor AI-training. Ontwikkelaars die ChatGPT gebruiken, kunnen hierdoor rekenen op nauwkeurigere en beter onderbouwde antwoorden op technische vragen. Voor Stack Overflow zelf is de toegang tot OpenAI's modellen een manier om hun eigen 'OverflowAI'-product te versterken. Hoe zal de community van Stack Overflow reageren op het feit dat hun bijdragen nu direct worden gebruikt om een commercieel product als ChatGPT te voeden?

|

Definitieve tekst EU AI Act gepubliceerd, tijdlijn voor handhaving bekendDe EU heeft de AI Act formeel aangenomen, waarmee de tijdlijn voor de implementatie en handhaving van 's werelds eerste omvattende AI-wetgeving vastligt. Na jaren van onderhandelen is er nu duidelijkheid over wanneer welke regels van kracht worden, wat bedrijven dwingt om hun AI-strategie en compliance-plannen te concretiseren. De eerste regels, met name verboden op bepaalde AI-toepassingen, treden al 6 maanden na de ingangsdatum in werking (eind 2024). Verplichtingen voor modellen als GPT-4 volgen na 12 maanden, en de zwaardere eisen voor hoog-risicosystemen na 24 maanden. Boetes kunnen oplopen tot 7% van de wereldwijde jaaromzet. De definitie van 'hoog-risico' AI-systemen is breed en de praktische implementatie van de regels zal voor veel organisaties een complexe en kostbare uitdaging worden. |

Amazon voltooit investering van $4 miljard in AnthropicAmazon heeft zijn toegezegde investering van $4 miljard in AI-ontwikkelaar Anthropic voltooid met een laatste tranche van $2,75 miljard. Deze investering, vergelijkbaar met de relatie tussen Microsoft en OpenAI, verstevigt de alliantie tussen een van de grootste cloud-providers en een toonaangevend AI-lab. Voor organisaties die op AWS bouwen, betekent dit dat de modellen van Anthropic (zoals de Claude 3-familie) een eersteklas burger worden binnen het Amazon Bedrock-ecosysteem. Anthropic zal AWS als primaire cloudprovider gebruiken en de custom AI-chips van Amazon inzetten voor toekomstige modelontwikkeling. Hoewel dit de concurrentie op de AI-markt aanwakkert, leidt het ook tot een verdere consolidatie waarbij de belangrijkste AI-modellen steeds nauwer verbonden zijn aan de drie grote cloud-spelers.

|

Microsoft lanceert Phi-3-vision, een compact multimodale AIMicrosoft heeft Phi-3-vision uitgebracht, een klein (4.2 miljard parameters) maar krachtig multimodale model dat zowel tekst als afbeeldingen kan interpreteren. Dit model past binnen de trend van 'Small Language Models' (SLM's), die efficiënt lokaal kunnen draaien op bijvoorbeeld een laptop of zelfs een mobiele telefoon. De mogelijkheid om een capabel multimodale model on-device te draaien opent de deur naar privacy-vriendelijke applicaties die grafieken lezen of objecten in beelden identificeren zonder data naar de cloud te sturen. Kleinere modellen zijn per definitie minder krachtig dan hun grote broers als GPT-4o. Voor complexe, genuanceerde taken zal de prestatie van Phi-3-vision waarschijnlijk tekortschieten.

|